Το «Μοντεράδικο» - Πως γίνεται το moderation

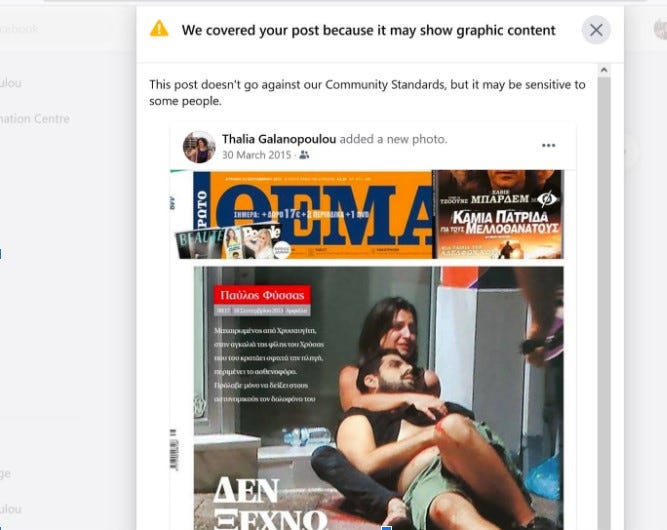

Από το ντοκιμαντέρ The Cleaners γνωρίζουμε ότι ακόμα και φωτογραφίες του Χίτλερ ή των Ναζί μπορεί να λογοκριθούν αυτομάτως και ότι οι moderators μπορεί να αδυνατούν να αναθεωρήσουν

Ο κυβερνοχώρος υπάρχει επειδή έχουμε δραστηριότητα σε αυτόν. Διαφορετικά, η μαύρη οθόνη παραμένει αυτό ακριβώς: μία μαύρη οθόνη. Στον φυσικό κόσμο υπάρχουν ρυθμιστικά συστήματα για την ορθή και δίκαιη κατανομή των κοινών πόρων. Η ρύθμιση γίνεται με τεχνικά μέσα, όπως λόγου χάρη είναι τα φανάρια του δρόμου, οι κάμερες ασφαλείας, οι ταμειακές μηχανές, αλλά και με νόμους που εφαρμόζουμε όλοι και επιτηρεί το κράτος.

Στο διαδίκτυο, ο πρώτος ρυθμιστής του λόγου είναι οι αλγόριθμοι, όπως εξηγήσαμε στα προηγούμενα σημειώματα. Επειτα υπάρχουν οι κανόνες κοινότητας την υποχρεωτική εφαρμογή των οποίων άρχισε να επιτηρεί το Facebook για πρώτη φορά επίσημα το 2018. Οι κανόνες αυτοί αφορουν σε παραβιάσεις που σχετίζονται με τα πνευματικά δικαιώματα, τη βία και την ασφάλεια, διαμαρτυρίες τρίτων, το σεβασμό της αξιοπρέπειας τους κοκ.

Οι κανόνες αυτοί επιτηρούνται τόσο απο αλγορίθμους όσο και απο moderators (ανθρώπους). Όταν λέμε αλγόριθμους εδώ, εννοούμε προγράμματα τα οποία χρησιμοποιούν φίλτρα λέξεων και μικρούς θησαυρούς ονομάτων και όρων, φτιαγμένα για να επιτελούν μία συγκεκριμένη λειτουργία.

Ένα απλό παράδειγμα του πώς λειτουργούν βρίσκει κανείς σε οποιαδήποτε δημόσια προσωπική σελίδα, όπου μπορεί να πάει στις ρυθμίσεις και να απαγορεύσει να εμφανίζονται υβριστικές, ή όποιες άλλες λέξεις δεν επιθυμεί να αναρτώνται.

Οι κανόνες αυτοί που υποβάλλονται σε συνεχείς αναθεωρήσεις και προσθήκες εφαρμόστηκαν και στην περίπτωση Κουφοντίνα.

Για παράδειγμα, το Facebook δεν αποσαφηνίζει με ακρίβεια τον ορισμό των «επικίνδυνων ατόμων και οργανισμών» στις οποίες κατατάσσει τη 17 Νοέμβρη και τον Δημήτρη Κουφοντίνα, παρότι γνωρίζουμε ότι προέρχεται από τον κατάλογο των τρομοκρατικών οργανώσεων και προσώπων που δημοσιεύει το State Department:

«Απαγορεύουμε τη δημοσίευση συμβόλων τέτοιων οργανώσεων χωρίς σχόλια που τις καταδικάζουν ή συζητούν για αυτές με ουδέτερο τρόπο. Δεν επιτρέπουμε περιεχόμενο που εξυμνεί (praises) τέτοιες οργανώσεις και άτομα. Δεν επιτρέπουμε τον συντονισμό για την υποστήριξη οιουδήποτε οργανισμού ή ατόμου με τα χαρακτηριστικά αυτά ή οποιασδήποτε πράξης που διενεργείται από αυτό».

Αν ξανακοιτάτε τις αναρτήσεις σας και αναρωτιέστε αν εμπίπτετε σε αυτούς τους περιορισμούς και πως έχουν αυτοί προκύψει, έχετε δίκιο: Είναι τόσο ανοιχτοί που χρήζουν ερμηνείας.

Ενώ παλιότερα μπορούσε να τυποποιήσει συστήματα ελέγχου κοινότητας σε δεύτερο βαθμό (flag, report), μετά τις τελευταίες αμερικανικές εκλογές, έχει προχωρήσει σε μια σημαντική μεταβολή. O έλεγχος περιεχομένου γίνεται σε πολλές περιπτώσεις προληπτικά και όχι μόνο κατόπιν καταγγελιών.

Για την ακρίβεια, καθώς η Πράξη για τις Ψηφιακές Υπηρεσίες (Digital Services Act) και η Πράξη για τις Ψηφιακές Αγορές (Digital Markets Act) που θα ρυθμίσουν τη λειτουργία των εταιρειών διαδικτύου στην Ευρώπη βρίσκονται υπό διαπραγμάτευση, φαίνεται πως είμαστε όλοι μέρος ενός μεγάλου πειράματος που διεξάγει το Facebook, προκειμένου να εφεύρει τους αλγόριθμους εκείνους που θα ρυθμίζουν το λόγο στο δίκτυο του με όσο πιο αυτοματοποιημένο τρόπο γίνεται.

Σύμφωνα με στελέχη του Facebook, αλλά και τον ίδιο τον Mark Zuckerberg το 98% των δημοσιεύσεων που περιέχουν ρητορική μίσους ή αναφέρονται σε καταγεγραμμένες τρομοκρατικές οργανώσεις, ελέγχεται πλέον από μηχανές. Οι αλγόριθμοι, οι οποίοι κάνουν λάθη, όπως στην περίπτωση Κουφοντίνα, υποτίθεται πως εκπαιδεύονται και βελτιώνονται μέρα με τη μέρα, ώστε να διασφαλιστεί η ποιότητα της υπηρεσίας, ισχυρίζονται οι ίδιοι, με τα ορατά σε όλους μας αποτελέσματα. Επιπλέον, ο ισχυρισμός πως είναι οι αλγόριθμοι που ‘λογοκρίνουν’ και όχι υπάλληλοι δεν έχει αποδειχθεί.

Μία προσεκτική ματιά στα παραδείγματα ορισμένων αναρτήσεων πού λογοκρίθηκαν, προσφέρει μία ισχυρή ένδειξη για αυτό. Για παράδειγμα, οι Υovel, ένα black metal συγκρότημα, λογοκρίθηκε για μία καταγγελτική φωτογραφία των Ναζί. Η black metal συχνά έχει σχέση με τους νεοναζί, όχι όμως στην περίπτωση των Yovel.

Δεν φανταζόμαστε ότι υπάρχουν moderators που έχουν συγκεκριμένα μουσικά γούστα και κόβουν όσες μπάντες δεν τους αρέσουν, αλλά ότι υπάρχει ένα σώμα λέξεων και εικόνων, που όταν βρεθούν στα ίδια συμφραζόμενα, προκαλούν συναγερμό.

Εν προκειμένω η φωτογραφία των Ναζί, η φωτογραφία κεράτων και ενδεχομένως κάποιες λέξεις, ώθησαν τον αλγόριθμό να θεωρήσει ότι πρόκειται για εξτρεμιστική ανάρτηση και να κάνει flag ή να την καταργήσει ωσότου τη δει ένας moderator.

Ο moderator που επιθεώρησε την απόφαση άργησε να καταλάβει ότι επρόκειτο για ουδέτερη η αρνητική αναφορά και γι’ αυτό αποκατέστησε την ανάρτηση μια μέρα αργότερα.

Από το ιδιαίτερα κατατοπιστικό ντοκιμαντέρ The Cleaners γνωρίζουμε ότι ακόμα και φωτογραφίες του Χίτλερ ή των Ναζί μπορεί να λογοκριθούν αυτομάτως και ότι οι moderators που κοιτάζουν τις αναρτήσεις έπειτα μπορεί να μην είναι σε θέση να κρίνουν και να αναθεωρήσουν την απόφαση.

επόμενο κεφάλαιο: Πως λειτουργούν τα moderation hubs